สร้าง Data Pipeline ด้วย Python, Airflow และ BigQuery พร้อมใช้งานบน Google Cloud

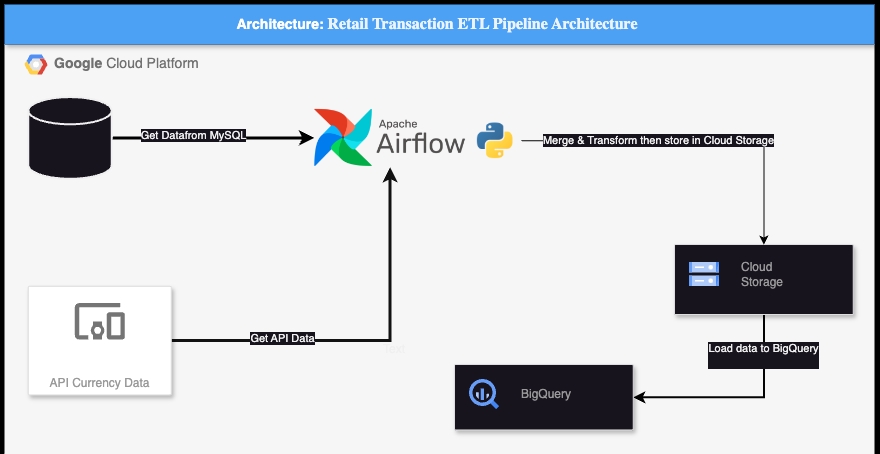

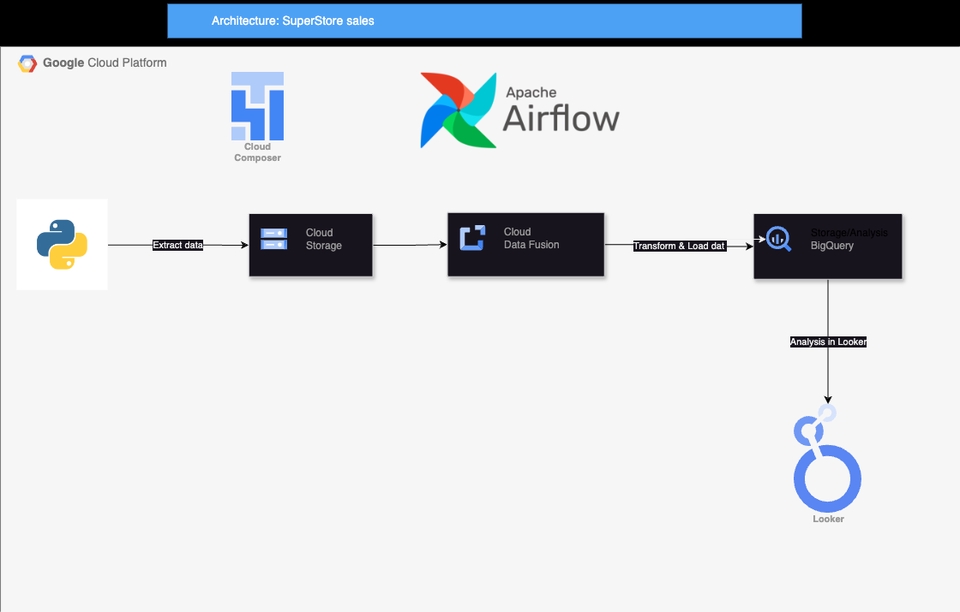

ผมรับออกแบบและพัฒนา Data Pipeline ตั้งแต่การดึงข้อมูล (Extract), แปลงข้อมูล (Transform) จนถึงการโหลดข้อมูล (Load) ไปยัง BigQuery หรือ Redshift โดยใช้ Python และ Airflow รองรับการทำงานทั้งบน Google Cloud Platform (GCP) และ Amazon Web Services (AWS) เหมาะกับธุรกิจที่ต้องการระบบจัดการข้อมูลอัตโนมัติ รองรับการวิเคราะห์และขยายขนาดในอนาคต จุดเด่นของงานนี้: ใช้เทคโนโลยีทันสมัย เช่น Airflow, BigQuery, AWS S3, Redshift รองรับ Cloud ได้ทั้ง GCP และ AWS ออกแบบ Pipeline ที่ยืดหยุ่น ขยายง่าย ใช้งานจริงได้ เขียนโค้ดคุณภาพ พร้อมคำอธิบายชัดเจน ส่งงานตรงเวลา ปรับแก้ตามคำขอได้ พร้อมให้คำแนะนำหากลูกค้าไม่มีพื้นฐานด้าน Data ขั้นตอนการทำงาน 1. การวิเคราะห์ความต้องการ (Requirement Analysis) รับข้อมูลจากลูกค้าเกี่ยวกับประเภทข้อมูลที่ต้องการจัดการ และระบบที่ใช้ (เช่น GCP, AWS) วิเคราะห์รูปแบบข้อมูล (structured, semi-structured, unstructured) และกำหนดวิธีการเก็บข้อมูล 2. การออกแบบระบบ ETL (ETL Design) ออกแบบขั้นตอนการดึงข้อมูล (Extract), แปลงข้อมูล (Transform), และโหลดข้อมูล (Load) กำหนดการใช้เครื่องมือ เช่น Python, Airflow, BigQuery หรือ AWS Redshift เขียนแผนการทำงาน (Pipeline design) และกำหนดเวลาในการประมวลผลข้อมูล 3. การพัฒนาและทดสอบ (Development & Testing) เขียนโค้ด Python สำหรับการดึงข้อมูล, แปลงข้อมูล และโหลดข้อมูล ทดสอบระบบการทำงานให้เสถียรและตรวจสอบข้อมูลให้ถูกต้องตามที่ลูกค้าต้องการ 4. การปรับปรุงและการตรวจสอบ (Optimization & Validation) ตรวจสอบประสิทธิภาพและความแม่นยำของข้อมูล เพิ่มการตรวจสอบข้อมูล (Data validation) และเก็บ Log หากพบข้อผิดพลาด 5. การส่งมอบงาน (Delivery) ส่งมอบโค้ดที่พร้อมใช้งาน พร้อมกับคำอธิบายวิธีการใช้งาน สอนลูกค้าเกี่ยวกับการใช้งานและการบำรุงรักษาระบบ

แพ็กเกจ: 3 แพ็กเกจ

Data Pipeline Basic

฿1,5001. Pipeline ดึง/แปลง/โหลดข้อมูล (ETL) ด้วย Python 2. ใช้งานบน GCP หรือ AWS (BigQuery / Redshift / S3) 3. Airflow DAG พร้อมใช้งาน 4. README วิธีใช้งาน + คำอธิบายโค้ด 5. ปรับแก้งานได้ 1 ครั้ง (โปรเจกต์แรกสำหรับลูกค้าใหม่ ลด 70% !!!!!!)

Data Pipeline + Validation

฿3,0001. พัฒนา ETL Pipeline จาก 2 แหล่งข้อมูล 2. เขียนด้วย Python + Airflow 3. รองรับ GCP (BigQuery/GCS) หรือ AWS (S3/Redshift) 4. เพิ่มระบบตรวจสอบข้อมูล (Data Validation) 5. เก็บ Log และแจ้ง Error ผ่าน Email/Log File 6. ส่งงานพร้อมโค้ด + README + ตัวอย่าง Output 7. ปรับแก้งานได้ 3 ครั้ง (โปรเจกต์แรกสำหรับลูกค้าใหม่ ลด 70% !!!!!!)

Full Workflow + Dashboard

฿5,0001. พัฒนา Workflow ครบทั้ง ETL, Validation, Load 2. รองรับหลายแหล่งข้อมูล (สูงสุด 3 sources) 3. Airflow + GCP (BigQuery/GCS) และ/หรือ AWS (S3/Redshift) 4. สร้าง Dashboard ด้วย Looker Studio หรือ Metabase 5. จัดทำรายงานผลเบื้องต้น (PDF/Excel/Google Sheets) 6. ส่งงานพร้อมคำอธิบาย + คู่มือใช้งานระบบ 7. ปรับแก้งานได้ 3 ครั้ง (โปรเจกต์แรกสำหรับลูกค้าใหม่ ลด 70% !!!!!!)

ฟรีแลนซ์สาย Data Engineer และ Backend Developer กำลังเรียนคณะ Computer Science ที่มหาลัย Assumption University มีประสบการณ์สร้าง ETL pipeline, วิเคราะห์ข้อมูลอสังหา พัฒนาแชทบอทแจ้งซ่อมผ่านไลน์ และระบบเว็บด้วย Go ทำงานตรงเวลา รับผิดชอบสูง เรียนรู้เร็ว พร้อมพัฒนาต่อเนื่อง Check my project that I have done detail : https://github.com/Thananontnc

ฟรีแลนซ์สาย Data Engineer และ Backend Developer กำลังเรียนคณะ Computer Science ที่มหาลัย Assumption University มีประสบการณ์สร้าง ETL pipeline, วิเคราะห์ข้อมูลอสังหา พัฒนาแชทบอทแจ้งซ่อมผ่านไลน์ และระบบเว็บด้วย Go ทำงานตรงเวลา รับผิดชอบสูง เรียนรู้เร็ว พร้อมพัฒนาต่อเนื่อง Check my project that I have done detail : https://github.com/Thananontnc

ทักแชทเพื่อคุยรายละเอียดและบรีฟงานกับฟรีแลนซ์ได้ทันทีโดยไม่มีค่าใช้จ่าย

ตกลงจ้างงาน โดยขอใบเสนอราคากับฟรีแลนซ์ ตรวจสอบรายละเอียดและชำระเงินได้ทันที

เมื่อฟรีแลนซ์ทำงานตามข้อตกลงและส่งงานขั้น สุดท้ายแล้ว ผู้จ้างสามารถตรวจสอบ ขอแก้ไขหรืออนุมัติได้ตามข้อตกลง

Fastwork เป็นตัวกลางถือเงินของคุณ เพื่อความปลอดภัย และฟรีแลนซ์จะได้รับเงิน หลังจากผู้ว่าจ้างจะกดอนุมัติงานแล้วเท่านั้น!