Data cleaning and transformation, ออกแบบฐานข้อมูลและ Data warehouse

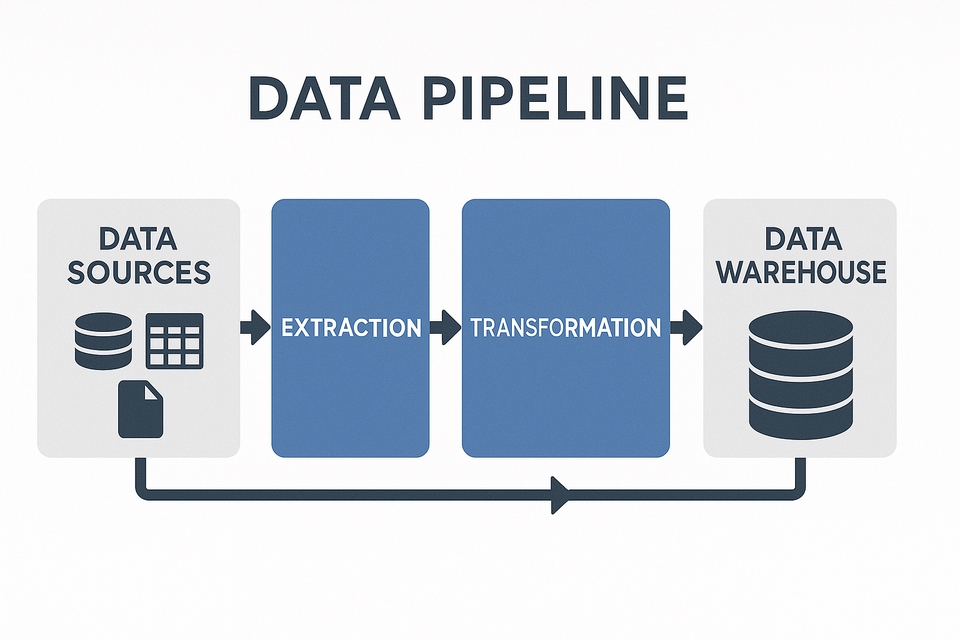

Data Engineer คือผู้เชี่ยวชาญที่ทำหน้าที่สร้างและดูแลระบบการจัดการข้อมูลตั้งแต่การเก็บ รวบรวม แปลง และส่งต่อข้อมูลจากแหล่งต่าง ๆ ไปยังระบบที่ใช้ในการวิเคราะห์หรือแสดงผล เช่น BI Tools หรือ AI Model โดยมีหน้าที่หลักคือการสร้าง “Data Pipeline” ซึ่งเป็นกระบวนการที่ทำให้ข้อมูลไหลเวียนได้อย่างเป็นระบบ ปลอดภัย และมีประสิทธิภาพสูงสุด หน้าที่ครอบคลุมตั้งแต่การดึงข้อมูลจากระบบ ERP, IoT, ไฟล์ CSV หรือ API จากภายนอก, ทำความสะอาดข้อมูลให้เป็นมาตรฐาน (Data Cleansing), แปลงข้อมูลให้เหมาะสมกับการวิเคราะห์ (Data Transformation), จัดเก็บในฐานข้อมูลหรือคลังข้อมูล (Database / Data Warehouse) และดูแลให้ระบบทำงานได้ตลอดเวลาแบบอัตโนมัติ นอกจากนี้ Data Engineer ยังต้องทำงานร่วมกับทีม Data Analyst, Data Scientist และ Software Engineer เพื่อให้แน่ใจว่าข้อมูลที่ได้มีความถูกต้อง ทันสมัย และสามารถนำไปใช้ตัดสินใจทางธุรกิจได้จริง โดยอาศัยความรู้ทั้งในด้านโปรแกรมมิ่ง (Python, SQL), เครื่องมือจัดการข้อมูล (Spark, Kafka, Airflow), การออกแบบฐานข้อมูล (Data Modeling) และ Cloud Platform อย่าง AWS หรือ GCP กล่าวโดยสรุป Data Engineer คือผู้ปูทางให้ข้อมูลพร้อมใช้งาน เพื่อสนับสนุนการตัดสินใจและการพัฒนาระบบอัจฉริยะในองค์กรยุคดิจิทัล. ขั้นตอนการทำงาน 1. ติดต่อสอบถาม 2. เนื้อหาของงานที่จะที่ลูกค้าต้องการเป็นแบบใด 3. Data ที่ลูกค้ามีทั้งหมด 4. ร่างแบบให้ลูกค้า 5. ยืนยันข้อตกลงก่อนเริ่มทำงาน 6. เมื่อทำงานเสร็จ ให้ลูกค้าตรวจสอบ 7. แก้ไขได้ 2 ครั้ง

แพ็กเกจ: 3 แพ็กเกจ

แพ็คเกจเริ่มต้น – “Basic Data Pipeline Setup”

฿15,000เหมาะกับ: ร้านค้า/SME/ฝ่ายบัญชีที่เริ่มใช้ข้อมูลเพื่อวิเคราะห์ • ระบบ ETL พื้นฐาน: ดึงข้อมูลจาก Excel/CSV/API • แปลงข้อมูลให้อยู่ในรูปแบบที่พร้อมใช้ (Clean & Normalize) • จัดเก็บข้อมูลใน Google Sheets / PostgreSQL / Excel เครื่องมือที่ใช้: Python (Pandas, requests), SQLAlchemy, Google Sheets API

แพ็คเกจมาตรฐาน – “Automated Data Pipeline & Dashboard Ready”

฿50,000สิ่งที่ลูกค้าจะได้รับ: • สร้างระบบ Data Pipeline อัตโนมัติ (เช่น อัปเดตข้อมูลทุกวัน) • ตั้งเวลาให้ระบบรันอัตโนมัติ (ใช้ Airflow หรือ Google Apps Script) • เชื่อมต่อกับฐานข้อมูล (เช่น PostgreSQL, BigQuery) • ส่งข้อมูลให้ทีมวิเคราะห์ผ่าน Google Sheets / Looker Studio เครื่องมือที่ใช้: Airflow, SQLAlchemy, Google BigQuery, Pandas เหมาะกับ: บริษัทขนาดกลางที่ต้องการระบบอัตโนมัติและพร้อมสร้าง dashboard

แพ็คเกจขั้นสูง – “Enterprise-Grade Data Platform”

฿150,000• สร้างระบบ Data Lake/Data Warehouse (รองรับข้อมูลขนาดใหญ่) • ประมวลผลแบบกระจายด้วย Spark / Dask / PySpark • ใช้ Cloud (AWS / GCP / Azure) สำหรับจัดเก็บและวิเคราะห์ • สร้างระบบ Monitoring แจ้งเตือนเมื่อ Pipeline ล้มเหลว • พร้อมสร้าง Data Model สำหรับใช้ใน BI Tools เครื่องมือที่ใช้: PySpark, Dask, Airflow, GCP BigQuery, AWS S3, dbt เหมาะกับ: โรงงาน, ธุรกิจขนาดใหญ่, หรือองค์กรที่มี Big Data และต้องการใช้ AI/ML ต่อ

นักวางแผนการผลิต | นักพัฒนาระบบ VBA และ ML รับปรึกษาด้าน Coding Python, VBA ปริญญาโท วิศวกรรมเทคโนโลยี (สถาบันเทคโนโลยีไทย-ญี่ปุ่น) ปริญญาตรี วิศวกรรมไฟฟ้า (มหาวิทยาลัยเกษตรศาสตร์ บางเขน)

นักวางแผนการผลิต | นักพัฒนาระบบ VBA และ ML รับปรึกษาด้าน Coding Python, VBA ปริญญาโท วิศวกรรมเทคโนโลยี (สถาบันเทคโนโลยีไทย-ญี่ปุ่น) ปริญญาตรี วิศวกรรมไฟฟ้า (มหาวิทยาลัยเกษตรศาสตร์ บางเขน)

ทักแชทเพื่อคุยรายละเอียดและบรีฟงานกับฟรีแลนซ์ได้ทันทีโดยไม่มีค่าใช้จ่าย

ตกลงจ้างงาน โดยขอใบเสนอราคากับฟรีแลนซ์ ตรวจสอบรายละเอียดและชำระเงินได้ทันที

เมื่อฟรีแลนซ์ทำงานตามข้อตกลงและส่งงานขั้น สุดท้ายแล้ว ผู้จ้างสามารถตรวจสอบ ขอแก้ไขหรืออนุมัติได้ตามข้อตกลง

Fastwork เป็นตัวกลางถือเงินของคุณ เพื่อความปลอดภัย และฟรีแลนซ์จะได้รับเงิน หลังจากผู้ว่าจ้างจะกดอนุมัติงานแล้วเท่านั้น!